Entropia

L'entropia e il disordine di un sistema. Calcolo dell'entropia

Il concetto di entropia (dal greco antico en = "dentro" + tropé = "trasformazione") ha origine da due diversi ordini di considerazioni: nella termodinamica classica si introduce l'entropia come funzione di stato di un sistema; nella meccanica statistica si assume l'entropia come indice del numero di possibili configurazioni, associate a uno stato del sistema, delle particelle elementari componenti il sistema stesso.

È importante sottolineare fin da subito che le due diverse definizioni coincidono, nel senso che identificano una grandezza che gode delle medesime proprietà caratteristiche.

Il concetto di entropia nella meccanica classica

Un'importante considerazione emersa durante lo sviluppo della termodinamica classica è la seguente: la quantità di calore necessaria per portare un corpo o, più generalmente, un sistema termodinamico da uno stato iniziale A a uno stato finale B non è definita in modo univoco, ma dipende dal modo con cui questo processo viene eseguito; in altri termini la quantità di calore dipende dal cammino percorso per passare dallo stato A allo stato B.

È possibile tuttavia definire un'altra grandezza, direttamente legata alla quantità di calore, che è univocamente determinata una volta noto lo stato in cui il sistema si trova. Se il cammino compiuto per passare da A a B è reversibile (cioè se tutte le variazioni che avvengono nei sistemi interessati possono essere annullate invertendo il senso della trasformazione), la grandezza

![]()

essendo T la temperatura assoluta, ha un valore che non dipende dal cammino percorso. A questo integrale Clausius (1865) diede il nome di entropia. È perciò, nella definizione classica:

![]()

essendo dQ una quantità di calore ceduta o assorbita in modo reversibile. L'entropia è quindi una funzione di stato termodinamica e dS risulta essere, a differenza di dQ, un differenziale esatto.

È utile sottolineare che non interessa tanto conoscere il valore assoluto dell'entropia in un certo stato, quanto valutare le variazioni della funzione entropia passando da uno stato termodinamico a un altro.

Per un processo ideale che avviene in modo reversibile, la variazione di entropia (∆S) può essere calcolata nel seguente modo:

![]()

dove Qrev è il calore scambiato nella trasformazione fatta avvenire in modo reversibile e T è la temperatura assoluta alla quale la trasformazione avviene.

La relazione precedente mostra che la variazione di entropia di un sistema che passa reversibilmente da uno stato ad un altro, è data dalla differenza di entropia di questi due stati e non dal cammino percorso nel passaggio dall'uno all'altro e perciò l'entropia è una funzione di stato. ∆S si esprime in unità entropiche (u.e.) la cui unità di misura è: cal/(mol · K) o J/(mol · K).

Per quanto riguarda l'entropia (S) occorre osservare che contrariamente a quanto avviene per l'entalpia e l'energia libera, essa può essere misurata in assoluto in quanto è pari a zero l'entropia di un cristallo perfetto alla temperatura di zero K (zero assoluto).

Pertanto, mentre si è convenuto di porre uguale a zero l'entalpia di formazione degli elementi nei loro stati standard (25°C e 1 atm), l'entropia di formazione per gli stessi è maggiore di zero e ha un valore ben definito.

Per una trasformazione chimica, la variazione di entropia viene calcolata nel seguente modo:

![]()

Nelle reazioni che avvengono con un aumento del disordine, l'entropia dei prodotti S(prodotti) è maggiore dell'entropia dei reagenti S(reagenti), per cui: ∆S > 0.

Nelle reazioni che avvengono con diminuzione del disordine, l'entropia dei prodotti S(prodotti) è minore dell'entropia dei reagenti S(reagenti), per cui: ∆S < 0.

Tenendo conto della definizione di entropia, il secondo principio della termodinamica può essere enunciato nel seguente modo: nei processi spontanei di un sistema isolato l'entropia S deve aumentare, cioè ∆S deve essere maggiore di zero (∆S > 0).

Trasformazioni reversibili e irreversibili

Supponiamo che un sistema isolato che si trova inizialmente nello stato A compia un processo spontaneo che lo porta nello stato B. Il fatto stesso che questo processo avvenga implica che l'entropia dello stato B sia maggiore dell'entropia nello stato A.

Se ora si desidera riportare il sistema nelle condizioni iniziali, si trova che un processo di questo genere è impossibile, poiché comporterebbe una diminuzione di entropia, in contraddizione col postulato fondamentale e contro l'evidenza sperimentale. Per questa ragione ogni trasformazione reale si dice irreversibile.

Si può tuttavia pensare al caso limite di una trasformazione in cui l'aumento di entropia tenda a zero. La trasformazione ideale in cui l'aumento di entropia è nullo si dice reversibile. Ogni trasformazione reversibile è necessariamente una successione di stati di equilibrio, in quanto in ogni punto della trasformazione il sistema non può trovare disponibile, per definizione, alcun altro stato a entropia maggiore. Perciò ogni trasformazione reversibile è sicuramente quasi statica. Non è necessariamente vero l'inverso, cioè si possono pensare trasformazioni quasi statiche non reversibili.

Il concetto di entropia nella meccanica statistica

La termodinamica classica si occupa solo degli stati macroscopici della materia; si interessa cioè soltanto delle proprietà sperimentalmente osservabili, senza occuparsi di quanto avviene a livello microscopico, cioè a livello delle coordinate atomiche. Per affrontare questo aspetto del problema bisogna utilizzare i metodi della meccanica statistica, essendo evidente l'impossibilità di descrivere in termini di meccanica classica il comportamento della miriade di particelle elementari che compongono un sistema.

Uno stato termodinamico, o macrostato, di un sistema è noto quando si conoscono i valori delle grandezze estensive a esso corrispondenti, come il volume, l'energia interna, il numero di moli dei sistemi componenti.

È peraltro chiaro che una descrizione di questo tipo lascia aperte moltissime possibilità per quanto riguarda le condizioni del sistema a scala atomica. In altre parole, un medesimo stato termodinamico può essere realizzato con un gran numero di microstati diversi. Se N è il numero di possibili microstati di un macrostato, la definizione di entropia diventa:

![]()

dove k è la costante di Boltzmann, cioè il rapporto tra la costante dei gas per mole R e il numero di Avogadro Na.

La quantità S definita dalla formula precedente può effettivamente considerarsi l'interpretazione statistica del concetto di entropia, in quanto questa variabile gode di tutte le proprietà attribuite all'entropia nella termodinamica classica. Il fatto che l'entropia di un sistema isolato tenda a un massimo significa che il sistema tende verso uno stato che ha il massimo numero di possibilità di realizzazione, cioè verso lo stato più probabile.

Infatti il numero di microstati associati a un macrostato è una misura diretta della probabilità di uno stato termodinamico. Quindi, se un sistema ha un valore di S minore del massimo raggiungibile, compatibilmente con i vincoli esistenti, ciò significa che il sistema non è nello stato più probabile e quindi non si trova in una condizione di equilibrio stabile.

Secondo la definizione la formula precedenete l'entropia si annulla quando esiste un solo microstato associato a un certo stato termodinamico. Ciò significa che esiste per ogni sistema un particolare microstato a cui corrisponde un minimo di energia e che, a temperatura zero, può esistere solo quest'unico microstato.

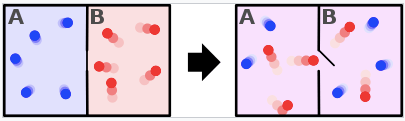

Da quanto detto risulta che la meccanica statistica interpretata l'entropia come una misura del disordine presente in un sistema fisico.

Nel sistema di destra l'entropia, ovvero il disordine, è maggiore.

Link correlati:

Che cos'è e come è definita l'entalpia?

Che cos'è e come è definita l'energia libera G?

Studia con noi